Texte repris et révisé en Converge1.html

Entre le quantum transactionnel et le système total

La convergence informatique

ET NOUS (dixit Pascal)

Notes et plaidoyer pour une recherche à naître. (En légende d'un dessin de Guibol: J'ai vidé mon sac. Il y a beaucoup à boire. Peut-être un peu à manger. Qui veut servir d'écumoire. Guibol).

Le fond des fonds, c'est le fonds monétaire. Einsteint Jr.

Table des matières

Informatique fondamentale

L'informatique est une architecture

L'informatique est une biologie

Science ou technique

Les oeillères des systématiciens

Information et énergie

Information et argent

Les parardoxes de la complexité

Un algorithme de la liberté

Aux objecteurs humanistes

Le complexe et le répétitf

L et les interfaces

Convergence et antisystème (I)

La mesure

La saisie des données

Les télécommunications

La convergence des informatiques

Convergence et antisystème (II)

Informatique fondamentale?

Plaidoyer pour une recherche à naître

L'informatique, en tant qu'industrie, semble avoir passé le plus mauvais Cap. Après un nettoyage qui a vu disparaître des entreprises, réduire des effectifs, comprimer des capitaux, une situation plus saine paraît s'instaurer.

Mais l'élan est tombé. On a trouvé la sagesse. Il faudrait peut-être aussi un certain souffle. Des idées neuves qui pourraient intéresser, donner envie aux responsables et aux utilisateurs de marcher encore dans la voie du progrès, avec les risques que cela comporte, mais aussi les charmes de l'aventure.

Quoi qu'ils en disent, chefs d'entreprise et pesonnels ne vivent pas seulement de leur feuille de paie, mais aussi de passion. De même que l'inflation est l'huile qui permet les réajustements et les évolutions (mais certes il ne faut jamais trop d'huile), de même l'innovation crée le champ dynamique où le dialogue (parfois sans pitié) entre jeunes et anciens, entre techniciens et gestionnaires et (le ciel nous entende) entre universitaires et industriels, trouve aliment.

Hélas, rien ne laisse attendre pour l'immédiat (ni même pour les quelques années qui viennent) l'apparition de ce second souuffle.

L'industrie informatique ne veut plus dépasser les formules qu'elle a si difficilement mises au point. Depuis un ou deux ans, les "nouveautés" annoncées ne portent plus que sur des points de détail. Publicitaires et journalistes s'efforcent à l'envi de voir des révolutions sous de micro-évolutions. Quitte à presque passer sous silence des vagues de fond comme l'invasion généralisée des circuits intégrés, qui ne modifient ni l'aspect extérieur des ordinateurs ni leur mode d'emploi. Tout au plus leur prix.

L'annonce récente par IBM, comme une grande nouveauté, de la mémoire virtuelle sur ses 370 illustre bien cet essouflement sur le plan du hardware. Quant au softwre, on demande des idées neuves. Les conférences faites par les porte-parole des sociétés de service, les entretiens qu'ils accordent aux journalistes pratiquent un discours ambigu. On affirme être sorti de la morosité. Mais, après avoir clamé bien haut que l'informatique est désormais un produit de grande consommation, a atteint une phase industrielle, on avoue que les "produits" sont encore très liés aux "services", et que les méthodes de marketing restent celles des cabinets conseils. Le catalogue des grandes écoles reste l'arme absolue des vendeurs. Si les SCI veulent "vendre des savonnettes",, elles auraient avantage à voir comment travaille Unilever!

Comme pour les savonnettes ou les lessives, l'innovation devrait venir des laboratoires de recherche. Et, derrière eux, de la recherche fondamentale.

Hélas, ce que l'on sait des travaux des universitaires a de quoi décourager d'avance les utilisateurs. Les instituts français (mais les américains ont-ils fait beaucoup mieux ces dernières années) n'ont pratiquement rien proposé de "consommable". Ni même vraiment réussi à convaincre l'industrie de la valeur des informaticiens formés, parfois à grands frais. Deux textes récents viennent encore renforcer cette impression déprimante.

Dans le bulletin de l'Iria no 11, Maurice Nivat tente "d'isoler et de délimiter aussi précisément que possible un domaine de recherche que, faute de mieux, nous appellerons Informatique Théorique". D'autre part l'OCDE, dans un tome de sa collection "Problèmes et perspectives de la recherche fondamentale dans les domaines multi-disciplinaires" traite de l'informatique sous l'autorité de quatre chercheurs: A. Caracciolo di Forino, S. Michaelson, Maurice Nivat et M. Schutzenberger. La rédaction originale de ce rapport date vraisemblablement du début de 1971 et, sous certains aspects, se réfère à une problématique encore un peu antérieur (notamment en insistant sans réserves sur la formation d'un nombre élevé de mathématiciens).

Les deux textes ne sont guère optimistes. Le rapport de l'OCDE fait une critique, par moments amère, de la politique de recherche suivie. Il note que "certaines des difficultés" relèvent de deux facteurs socio-historiques particuliers:

- l'existence d'une grande industrie qui joue un rôle dominant en matière de développement;

- la nouveauté de cette matière, qui en fait une sorte de "Far West" sur le plan intellectuel.

Maurice Nivat laisse une impression encore plus pessimiste: "Depuis 15 ans, l'informatique théorique ne s'est que peu développée... Il s'agit d'un problème extrêmement difficile où bien peu de résultats sont déjà acquis, et dont la définition même prête à controverse" (il s'agit il est vrai de l'algorithmique de la parallélisation, c'est à dire du multi-traitement). "Il nous paraît difficile de voir appliquer dans un proche avenir...".

Les conclusions, bien sûr, ne sont pas négatives. Le rapport OCDE émet un certain nombre de recommandations, visant pour l'essentiel à concentrer dans les mains des mathématiciens "sérieux" la quasi-totalité des crédits consacrés à la recherche en informatique. et Maurice Nivat croit "que déjà l'on peut voir se dessiner les contours d'une problématique et la possibilité d'unifier les efforts".

Mais cette stérilité que déplorent les mathématiciens, n'en sont-ils pas les premiers responsables?

Le splendide isolement

"Nous ne cherchons absolument pas à présenter les revendications d'un groupe d'invididus égoïstes, soucieux de préserver leur tour d'ivoire", plaident les auteurs du rapport OCDE. Pieuse protestation, démentie par tout le reste du rapport. Nous voulons bien croire que les intentions sont pures, mais à ester trop enfermé dans une tour, fût-elle d'ivoire, on devient nécessairement quelque peu égocentristes. Ecoutons-les plutôt.

"Nous considéraons la conception de la structure interne des éléments fonctionnels du hardware comme relevant de la physique t de la technologie".

"Les recherches visant à améliorer l'utilisation des alculateurs dans la banque, l'industrie pétrolière, les iagnostics médicaux, l'urbaniqme, le dessin industriel des utomobiles, l'organisation scientifique du travail, etc. ne devraient pas être considérées comme appartenant à l'informatique proprement dite...".

"Les chercheurs en informatique devraient aborder le problème des banques de données comme un problème de caractère énéral et non pas sous l'angle de la documentation automatique ou des sciences de la gestion".

"Les applications que nous venons de citer (un rapide panorama vient d'en être dressé) sont externes à l'informatique comme telle". Et d'ailleurs "la plupart des applications des calculateurs sont extrêment simples et n'exigent aucune recherche fondamentale en informatique".

Que reste-t-il aux informaticiens? Partis d'une définition très générale de l'informatique (science multi-disciplinaire qui s'attache à l'étude systématique de la structure, du stockage, de la transmission et de la transformation de l'information), on en vient à la limiter à la concpetion interne des éléments du software, complétée par des travaux si possible complètement abstraits concernant la "programmation théorique" et la "méthodologie mathématique".

Cet isolement intellectuel volontaire se complète d'un mépris affiché pour les non mathématiciens, qui sont tout à la fois incompétents et malhonnètes. Citons encore.

"Les énormes intérêts financiers qui sont impliqués dans la promotion de la science des calculateurs ont plus ou moins façonné les besoins supposés de la société".

"Ils (les constructeurs) visent à mettre au point un produit qui puisse être lancé sur le marché à une date donnée: il ne s'agit pas en général de recherche. Il ne s'agit même pas, dans la plupart des cas, de travaux sérieux en matière de technologie".

"... la horde de "spécialistes" à l'esprit étroit et insuffisamment formés..."

"... l'évaluation des résultats dans ce domaine est presque entièrement confiée à des non mathématiciens... lesquels ... financent et encouragent les travaux qui n'ont parfois aucune valeur...".

Il en découle, bien entendu, que les organes de financement devraient être constitués par des "comités scientifiques composés de chercheurs qualifiés". Payez, et ne vous occupez surtout pas du reste.

Le pire, c'est que ces auteurs sont certainement sincères. Mais c'est la conception même qu'ils se font de leur discipline qui les conduit à ces revendications de splendide isolement.

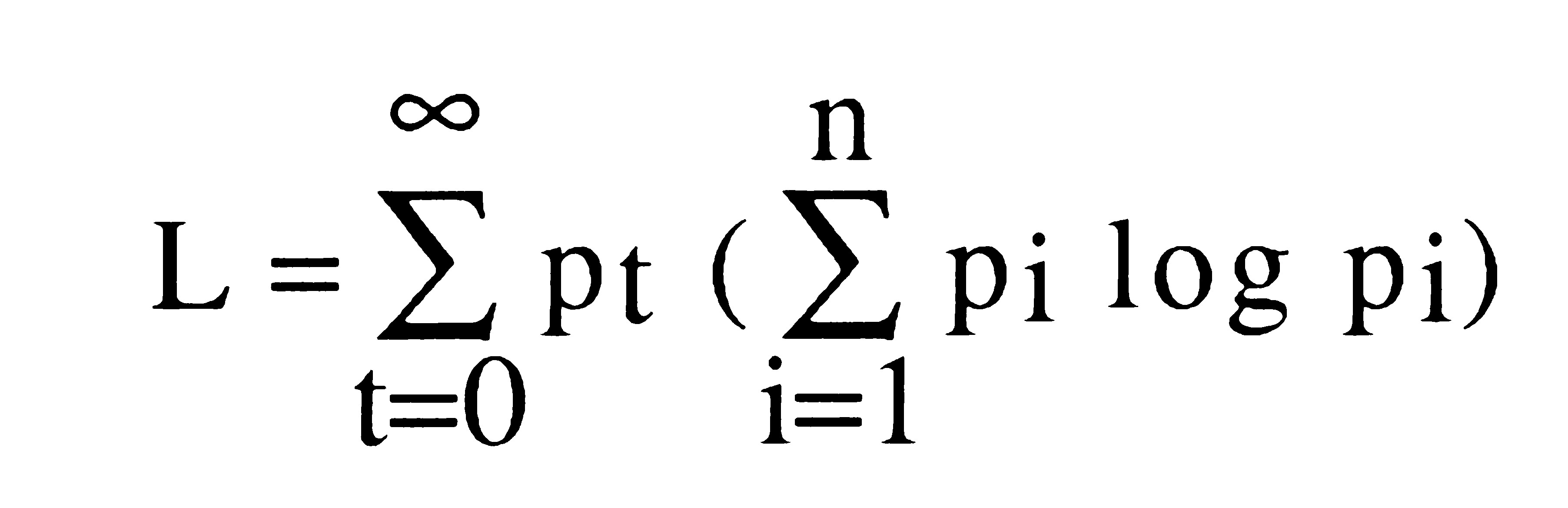

Maurice Nivat donne peut-être la clé du malentendu quand il écrit: l'algorithme consiste pour nous en l'étude de la chaîne:

codage

objet mathématique ---------> objet représenté ------!

--------------------------------------------------------!

opération décodage

------------> objet représenté -----------> objet mathématique.

Si, bien sûr, il ne s'agissait que de celà, il serait légitime de considérer l'informatique comme une discipline mathématique (Parallèlement, M. Nivat considère que c'est la notion de calcul qui est au centre de l'informatique théorique.).

La réalité est autre, sauf pour les applications scientifiques mathématiques par nature. Les informations qui parviennent aux systèmes informatiques ne sont pas des objets mathématiques. Et, à un mondre degré, ce que l'on demande à l'informatique n'est pas non plus tout à fait un objet mathématique.

C'est précisément une des tâches essentielles des concepteurs de systèmes que de déceler, sous la confusion du réel, des structures formalisables et automatisables, et d'agir par tous les moyens nécessaires pour rendre cette automatisation efficace. Moyens mathématiques et technologiques sans doute, mais tout autant aussi moyens humains.

L'informatique est une architecture

A la différence du domaine nucléaire, l'informatique n'est pas née de l'application pratique de découvertes théoriques. Ici, la technique a toujours précédé la théorie:

- Pascal invente la pascaline pour calculer plus aisément les feuilles d'impôts des contribuables de la région de l'Ouest où il avait été envoyé en mission

(note, sans doute vers 80: en fait, ce n'est ni l'objectif ni la théorie qui sont premières, c'est la "conception de système", du couer de celui-ci, qui fait la passion des chercheurs).

- Le dispositif à cartes perforées de Hollerith est développé parce que moins cher que les solutions "classiques"

- Les besoins militaires allemands (Zuse) puis américains font mettre au point les premiers calculateurs électroniques (rappelé par le rapport OCDE).

Seul Babbage, peut-être pourrait faire exception. Mais est-ce à la gloire de la théorie?

René Carmille remarque dès 1938:

(la citation manque)

Et le rapport OCDE note clairement: "La science des calculateurs s'est édifiée à partir de nos tentatives pour mettre au point des outils propres à faciliter la solution des problèmes d'autres disciplines, d'où le rôle très particulier et important des applications dans le développement de cette science".

Mais:

- le rapport ne reconnaît ce rôle que pour en souhaiter la fin au nom d'une "distincation claire", comme on l'a vu plus haut;

- il mesure la fécondité des applications non pas en termes d'utilité sociale ou d'insertion dans un mouvement historique général, mais en termes d'utilité pour les chercheurs en informatique théorique: "certaines applications seront fructueuses et feront émerger des problèmes fondamentaux..."

D'ailleurs, les éléments constitutifs de la "science informatique" sont fort disparates. L'algèbre de Boole, la théorie de l'information de Shannon, les automatdes de Kleene, la linguistique chomskienne, les neurones de McCulloch et Pitts, la cybernétique de Couffignal ou de Wiener, les théories des systèmes de Bertallanfy our de Mesarovic... autant de sorces diverses. Pour la plupart, ces théories ne sont pas nées de l'informatique. M. Nivat le remarque pour les automates et, de même que R. Carmille, trouve cela "chose assez surprenante".

Il n'existe pas, aujourd'hui, une science que l'on pourrait appeler l'informatique. Il n'existe qu'un certain nombre d'agrégats de théories qui trouvent leur cohérence dans la construction concrète de systèmes informatiques opérationnels.

Très vite, on devait s'apercevoir que, pour ces systèmes, le calcul (à moins de lui donner une signification si large qu'elle perd toute valeur pratique)

En s'assimilant la mécanographie, le calculateur apprit qu'il lui fallait, pour progresser, apprendre à stocker de l'information (et, en pratique, à plusieurs niveaux) et se munir de dispositifs "d'entrée-sortie".

Ces derniers n'ont jamais fait le bonheur des informaticiens. Et il est vrai que la programmation en langage de base des éditions n'a rien de noble ou d'intellectuellement excitant, alors que c'est pourtant un aspect fondamental de l'efficacité des systèmes informatiques. L'apparition dest terminaux et des systèmes de gestion de transaction donne une nouvelle dimension aux problèmes. Mais, là encore, bien peu de choses ont été écrites sur l'emploi optimal des écrans cathodiques... les "filles" suivront.

(note 92: les filles, sont le personnel, essentiellement perfo-vérif, qui à l'époque assurait encore la saisie)

Au delà du calcul, l'informatique est donc l'art de concevoir et de réaliser des systèmes d'information, susceptibles de s'insérer efficacement dans l'univers concret des entreprises, des administrations, des usines ou des laboratoires scientifiques. L'informaticien est essentiellement un architecte.

Pour lui, comme pour le constructeur d'un pavillon ou d'une "tour", les sciences sont le moyen essentiel de faire mieux, plus utile, plus efficace, plus rentable. Et, à l'occasion, plus agréable pour les utilisateurs.

Les sciences? Mais pourquoi les seules mathématiques? Ces systèmes sont faits pour des hommes. Et les sciences humaines devraient jouer dans leur conception un rôle au moins aussi important que les sciences dites exactes. L'informatique manifeste clairement l'impossibilité où nos socétés ont été, jusu'à présent, de donner dans leurs organisations la place qui devrait revenir aux sociologues, psychologuqes, etc. Ceux-ci n'ont sans doute pas toujours fait ce qu'il fallait pour se faire ademttre. Et les discours qu'ils tiennent sont au moins aussi ésotériques que ceux des informaticiens. Mais on peut toujours prétendre que l'ordinateur n'est qu'un outil. C'est rassurant et peut-être efficace. Pour se défendre du spécialiste des sciences de l'homme, il ne reste qu'à le fuir ou à le traiter de "psychopitre"... ce n'est pas la même chose.

Au passage, notons que c'est sans doute à partir de ce point de vue de l'architecture que l'on peut utilement étudier le fait que le software est un produit ou un service. L'architecte utilise des moyens de plus en plus industrialisés. Dans certains cas, le préfabriqué complet est même possible. Mais, la plupart du temps, la part de "service" reste considérable tant pour la conception que pour la mise en oeuvre.

Le rapport OCDE note plusieurs fois le caractère dialectique de la conception des systèmes: "On s'attache à l'amélioration de l'efficacité des langages en tenant compte de l'ensemble des contraintes tenant à l'environnement économique et social... la mise au point d'un système de calcul est un processus itératif d'interaction entre le concepteur et l'utilisateur, au cours duquel l'utilisateur définit plus clairement son problème, cependant que le concepteur met au point les spécifications du système".

Mais il ne voit pas que ce processus itératif est le coeur même de l'informatique, et que l'informatique théorique ne progressera vraiment qu'en faisant la théorie de ce processus. Bien au contraire, on choisit de laisser l'utilisateur en dehors. Il arrive ce qui devait arriver: l'utilisateur (ou, si l'on préfère, l'utilisation) est le fautif: "Un grave obstacle à une étude approfondie des possibilités des systèmes de calcul tient à ce que nous n'avons aucun moyen de décider a priori si un système est bien ou mal adapté à un type donné d'application... la situation se complique encore...".

A un niveau différent, on retrouve le problème de l'informaticien s'étonnant de rencontrer des "problèmes humains" quand il essaie d'imposer unilatéralement, appuyé sur la direction générale, les solutions qui lui paraissent (de toute évidence) les meilleures.

Le rapport OCDE est tout de même très conscient des problèmes, puisqu'il parle ensuite de "technologie créatrice". mais le choix même du terme laisse prévoir les conclusions. Puisqu'il s'agit de technologie, il ne s'agit pas de recherche. Donc, le chercheur n'étudiera pas ces problèmes. Et par conséquent, on n'en sortira jamais.

S'étant reconnu architecte, l'informaticien va s'efforcer d'embrasser courageusement tout le champ concerné par ses constructions. Concepteur d'un système de gestion, il va lui falloir apprendre la gestion. Concepteur d'un MIS (note 92: Managemnet Information Systems), il apprendra le management. en tous cas, il aura son mot à dire sur tout, dans l'entreprise. N'est-il pas, finalement, l'architecte du système d'information, c'st à dire finalement du système tout court?

Hélas, parvenu à ces sommets, l'informaticien s'aperçoit qu'il manque d'air. En effet:

- plus ou moins implicitement, il en vient à revendiquer des responsabilités qui dépassent largemnt le champ de l'informatique. Et s'il revendique d'être lui-même le patron, il s'apercevra qu'il a d'autres responsabilitéq que les "systèmes"... qui trop embrasse, mal étreint.

- les outils qui lui seraient nécessaires n'existent nullement à ce niveau. Certes, une "approche systèmes" se révèle féconde. Mais il s'en faut qu'il existe à ce jour une véritable théorie des systèmes, cohérente et suffisamment développée pour être autre chose qu'un moyen d'éclairage utilise mis à manipuler avec précaution.

Déjà, avant l'informatique, d'autres avaient tenté l'ascension, poussés par la logique même des implications de leur discipline. Tout à tour, ingénieurs (il y a longtemps, au XIXeme siècle), comptables (années 30 à 50), chercheurs opérationnels (50 à 60), voire même cybernéticiens, ont revendiqué les responsabilités centrales, à tout le moins, une dépendance direte du "patron" et son appui "inconditionnel" vis à vis des autres responsables de l'entreprise. (* Sans oublier les rêves de "rois philosophes" dans l'antiquuité)

Tour à tour, ils ont été renvoyés à leurs machines, à leurs comptes, à leurs algorithmes, ou même ont disparu. Qui parle aujourdh'ui de cybernétique?

Après avoir cru absorber le conseil en management, l'organisation traditionnelle, etc.... l'informatique parvient à une crise d'identitité, bien mise en lumière par les évolutions des "SCI" (*Services et conseils en informatique, sigle remplacé ensuite par SSCI) . La crise intellectuelle coïncide avec une crise financière.

On ne peut donc pas définir l'informatique uniquement comme une architecture.

L'informatique est une biologie

L'ordinateur est une création de l'homme. Et, comme tel, il est susceptible d'une description complète. Il n'y a rien en lui qui dépasse ce que nous savons faire et contrôler.

Oui, mais.

Qui, aujourd'hui, connaît la totalité d'un système informatique, depuis son software d'application avec son mode d'emploi jusqu'à la chimie des circuits intégrés qui le composent? Quelques concepteurs exceptionnels, peut-être. Pour, dans le monde, des centaines de milliers d'informatciens. Qui ne s'en portent pas plus mal. Dans l'immensité d'un grand système informatique, chacun découpe les zones qu'il doit connaître pour effectuer son travail: concevoir le hardware, concevoir un système d'exploitation, former des utilisateurs, pupitrer, maintenir, etc. Pour la plupart, ce qui se passe derrière les carters, c'est la "boite noire" dont on connaît suffisamment le comportement pour le conduire. On en sait autant d'un cheval.

Mieux. Même si l'on savait le "tout" d'un système, bit par bit et transistor par transistor, cela ne suffit plus pour en prévoir le comportement pratique dans un environnement complexe de temps réel et de multi-programmation. C'est pourquoi l'on développe aujourd'hui des outils de "métrologie" où l'apparition des statistiques est absolument indispensable si l'on veut obtenir des résultats significatifs. Gibson Mix, moniteurs et softwares d'analyse de travau sont nécessairement utilisés de manière statistique. le système a un comportement. On connaît des moyens de l'"optimiser", c'est à dire de l'améliorer. On en sait autant d'un cheval.

L'ordinateur n'est qu'un outil? Certes. Mais, parvenu à ce point de complexité qu'on ne peut lui refuser le statut d'une certaine autonomie. Il suffit de couper le courant pour qu'il s'arrête? Si vous voulez qu'il s'arrête définitivement, c'est plus compliqué que cela. Peut-être plus difficile que d'assomer un lapin.

L'ordinateur a un mode d'existence propre. Une cohérence inédite dans le monde des artefacts.

(Note, quasi contemporaine du manuscrit je pense): Cet "automate électronqiue de traitement de l'information" a fait ses preuves et représente un investissement (financier, intellectuel, mytnique) qui lui garantit une substantielle longévité. De plus, aucune technologie actuellement imaginable ne paraît mettre en cause ses structures fondamentales actuelles. Le calcul analogique est désormais limité à quelques applications. La fluidique, le calcul optique, les supra-conducteurs, resteront probablement des curiosités de laboratoire ou de quelques domaines limités. Seules, les mémoires assocaitives ou les hardwares flous offrent une alternative, à ce jour fort lointaine, maême au plan des purs concepts).

Plus loin que l'individu ordinateur, les systèmes informatiques s'organisent en espèces. S'engendrent les uns les autres au fil des générations. Et ce n'est pas par hasard que les grands systèmes portent la trace des concepts qui firent naître leurs parents à lampes ou leurs grands parents mécanographiques.

(Note, idem. C'est parce que les lois profondes de génération des espèces s'appliquent à lui comme aux phyla du cheval ou du primate).

Du point de vue épistémologique (c'est à dire quant à la connaissance que nous pouvons en avoir), l'informatique offre nombre de points communs avec la biologie. Et il se trouve qu'effectivement, l'épistémologie de cette dernière offre des approches qu'il est fort intéressant d'appliquer à l'informatique.

A partir de cet objet essentiel qu'est le vivant, la théorie peut s'orienter soit vers l'atomisme, avec la réduction progressive du complexe au simple: de l'organisme à l'organe, de l'organe à la cellule, de la cellule à la molécule et à l'atome, soit vers les totalités: de l'individu à la famille, à la horde, à l'espèce, au genre, à la biosphère dans son ensemble. On lira, par exemple, "Biologie, théories du développement et dialectique", par Czeslaw Nowinski, dans le tome "Logique et connaissance scientifique" de l'Encyclopédie de La Pléïade.

C'est l'approche atomistique, et elle seule, que les mathématiciens proposent pour l'étude théorique de l'informatique. Le calcul binaire, le monoïde libre, les neurones de Mc Culloch montrent clairement la voie qui est choisie. Et, de même que le biologiste se renfermera méthodiquement sur de petits problèmes, laissant loin en avant de lui l'approche du vivant dans son ensemble, de même Maurice Nivat insiste sur la différence de degré de complexité entre les systèmes réels et les objets actuels de l'algorithmique ou de la "sémantique formelle des langages de programmation".

Mous pourquoi ne pas reconnaître l'intérêt et la valeur théorique d'études totalisantes analogues aux classifications de la zoologie, à la génétique des systèmes et à leur écologie?

Nous y reviendrons. Mais cette ouverture fait sentir la remarquable consistance de l'objet "système informatique". De même que l'improbable vivant a su progressivement se dégager du bouillon originel, jusqu'à affirmer sa maîtrise de plus en plus forte sur l'univers, de même l'ordinateur -mais ici sur un plan différent puisqu'il est essentiellemnet un artefact- affirme sa permanence et poursuit son développement au fil des ans.

Et cette consistance, originale mais forte et certaine, fonde la spécificité de l'architecture informatique. Ni la recherche opérationnelle ni la cybernétique n'ont pu solidement fonder leur pérennité, parce que les structures sur quoi elles se rondaient (algorithmies, homéostases par feed-back) n'avaient pas le degré suffisant de complexité et d'autonomie.

Les informaticiens n'ont donc pas à s'inquiéter pour leur avenir: le dynamisme et la volonté de vivre (tout en n'étant qu'induits par le dynamisme des sociétés humaines) des systèmes informatiques garantit pour longtemps encore la spécificité de leur rôle.

Science ou technique ?

L'informatique est-elle une science ou une technique? Il s'agit peut-être d'une question académique. Mais peut-être les points de vue exprimés permettent-ils de donner une réponse.

Une science est une discipline essentiellement spéculative: on étudie, on expérimente pour connaître une réalité qui s'impose comme extérieure, comme objective.

Une technique vise à construire quelque chose, en général pour en retirer quelque bien, quelque utilité.

De nos jours, science et technique s'entremêlent de plus ne plus. L'histoire de la science nucléaire reflète de bien près l'histoire des outils que l'on a conçus et réalisés pour explorer l'atome.

Dans les domaines biologiques, les interventions de l'expérimentateur se font de plus en plus profondes. Jean Rostand est-il un savant ou un technicien? On pourrait parfois en douter si ses "créatures", par le perfectionnement de son art, devenaient viables et valables. Mais où classera-t-on le généticien qui met au point de nouvelles espèces de maïs ou de blé? Technicien, certes, mais si près du savant... On va vers un "engineering biologique" où la part du spéculatifs et du technique seront de plus en plus difficiles à dégager l'une de l'autre.

Pour prendre une comparaison informatique, on pourrait dire que le savant fait une consultation pendant que le technicien fait une mise à jour. Mais on réalise finalemnet, aujourd'hui, des systèmes où les deux notions se combinent dans celle de "transaction".

Plus généralement, les relations de l'homme à la nature ne se décomposent plus en une contemplation mystique (ou stoïcienne) et une action profane (ou prométhéenne), au travers d'actes répétitifs. Praxis et noësis se fondent dans des actes uniques.

Dans cette explosion de l'épistémologie, le calculateur joue un rôle exceptionnel: une abstraction efficace.

Dans le concret, autour de ce foyer de convergence du spéculatif et du pratique, les deux approches, atomistique et totlisante, restent distinctes. Nous ne pouvons donc éviter de les étudier séparément, en commençant par l'approche totalisante, parce qu'elle est restée fort sous-développée jusqu'à présent.

L'Ordinosphère

Je n'aime guère ce titre. Je le garde faute de mieux, car il renvoie au vocabulaire de Teilhard de Chardin, qui se reconnaîtrait peut-être un peu dans les paragraphes qui vont suivre.

Recherche des totalités dans l'existence concrète des systèmes. Voilà le plan : partons de l'ordinateur lui-même pour nous étendre progressivement aux niveaux successifs de son environnement.

Le hardware

Quelques lois générales ont été dégagées.

La loi de Grosch, par exemple, pose que la puissance de calcul d'une machine croît comme le carré de son coût. On s'est d'ailleurs aperçu que la loi, exacte au niveau du hardware, pouvait être trompeuse en matière de systèmes informatiqeus pris avec leur environnemnet. L'efficacité des équipes de programmeurs ne croît pas comme le carré de leurs effectifs. On a bien au contraire remarqué -ans en faire de statitiques précises- que "jamais un façonnier n'a gagné d'argent avec des matériels plus gros que les 360/40". (*Note en 2011 : il semble qu'en fait il se soit agi d'une décision d'IBM pour des raisons purement commerciales, pour encourager l'acquisition de plus grosses machines, et non d'une loi à base technique comme la loi de Moore).

Les travaux de M. Duvergger sur les petits ordinateur peuvent se classer ici. Classification synchronique et étude des filialisations de classes de calculateurs mériteraient d'être mieux mis en lumière. Cette histoire paraît encore trop jeune, aux informaticiens expérimentés, pour qu'on l'écrive. Les débutants en jugent souvent autrement. D'ailleurs, les racines se prolongent au delà de l'informatique proprement dite. Nombre de caractéristiques des calculateurs d'aujourd'hui ne peuvent trouver leur explication que dans ces filiations. (*je pensais peut-être, en particulier, aux enregistrements sur bande magnétique, souvent groupés par 80 caractères, un héritage des cartes perforées).

Il est vrai que les mécanismes de causalité sont dans une large mesure cachés dans les dossiers des constructeurs. Mais, outre qu'ils sont peut-être disposés à ouvrir certains tiroirs. Les approches puremnet externes, purement objectives peuvent être valables. Même aux commerciaux, la technique parfois s'impose.

Dans toutes ces approches, les problèmes de nombres, de temps de coûts (il y avait tant d'ordinateurs de telle valeur, à telle date) sont essentiels. La paléontologie le sait désormais. Pourquoi l'informatique serait-elle en retard?

Le software

Des études semblables pourraient être faites sur le software. Les filiations sont ici peut-être encore plus nettes. On change plus facilement de machine que de système d'exploitation. L'histoire est plus courte, cependant, car la nécessité du software n'apparut que longtemps après l'émergence du hardware.

Les racines, d'ailleurs, sont plus diffuses, plongeant autant dans les bureaux du "fonctionnel" que dans le roc relativement solide de l'"organique".

Le dialogue homme-machine

Il est légitime d'étudier la botanique indépendamment de sa relation au jardinier. C'est autrement contestable pour l'informatique, artefact par essence.

Bien peu de choses ont été écrites sur l'homme informaticien, hors des éditoriaux humanitaires ou poliiques. (Voir cependant le dossier publié par Informatique et gestion de mai 1971, qui comporte une bibliographie).

Les systèmes informatiques sont conçus et utilisés par des individus. Ils induisent chez eux des réactions: fascination, crainte, attachement affectif.

La psychologie expérimentale qu'il faudrait mettre en oeuvre exige des moyens assez coûteux. Et les psychologues comme les biologistes préfèrent souvent des domaines plus aisés comme le comportement de la mouche drosophile ou de la souris blanche

Il sagit pourtant d'études intéressantes sur le plan même de la psychologie. les recherches d'un Cohen (Les robots humains dans le mythe et dans la science) mériteraient d'être poursuivies.

Mais ces études ne seraient pas inutiles en pratique. On connaît au moins un informaticien suicidaire. La sécurité des systèmes exige des responsables au psychisme solide. le développement des langages de programmation et des langages d'analyse devrait aussi y faire appel. On disait autrefois que pour apprendre l'anglais à Paul, il fallait d'abord connaître Paul. A fortiori quand il s'agit de concevoir un langage neuf. Algol est sans doute une splendide construction. Ce n'est pas un langage utilisable par les informaticiens.

Les années 50 virent quelques recherches intéressantes sur la gymnastique des "perfos", sur la "perforation au son". tout cela a été oublié. Un constructeur a récemment lancé "la saisie confortable".

Sans doute, une large part de ces études relèvent-elles de l'ergonomie ou de l'organisation des bureaux plus que de l'informatique. Mais, tant par l'aspect architectural de la conception des systèmes que par la dépendance fondamentale des ordinateurs, une partie de ces études, leur aspect formel, les conséquences qu'elles ont sur la structure des machines, elles figureraient légitimement dans les cadres de l'informatique fondamentale.

L'informatique et la société

Les travaux de Claudine Marenco, de Catherine Ballé et Jean-Louis Peaucelle sont l'oeuvre de sociologues. mais, pour les mêmes raisons que la psychologie, une part de leurs résultats relèvent de l'informatique fondamentale. Notons qu'il est essentiel, pour comprendre, même la structure hardware des systèmes, de savoir que dans l'ensemble les ordinateurs appartiennent à des corps sociaux et non à des individus: le développement de la multi-programmation, des protections mémoire, des systèmes à terminaux ne s'explique que de cette façon.

Au lieu de reprocher aux constructeurs leur excessif esprit commercial, une approche socio-économique pourrait cerner leur rôle dans le développement de l'informatique.

Mais, ici encore pour le biologiste, l'informaticien se sent toujours menacé par la "philosophie". Et l'on reconnaîtrait bien des informaticiens dans cette phrse de F. Meyer ( in Logique et Connaissance scientifique, La Pléïade): "Tout ce que se permet le biologiste, c'est de quitter parfois le terrain de la stricte observation pour se donner au niveau de la vulgarisation ou du discours académique, la détente de quelque théorie personnelle qui ne tarde pas à déboucher sur une profession de foi... bon nombre de biologistes restent sans doute très sensibles à la spécificité de leur champ de recherche... mais sans jamais prendre l'offensive conceptuelle qui paraît s'imposer".

Les oeillères des systématiciens

Outre la hiérarchie de niveaux de globalisation dont nous venons de parcourir les potentialités pour une recherche fondamentale, un autre ensemble théorique devrait être développé: l'évolutionnisme des systèmes en général (ce qui bien sûr dépasse l'informatique) et des systèmes informatiques en particulier.

Les instruments conceptuels d'approche de cet évolutionnisme pourraient être trouvés dans le domaine biologique, et plus généralemnet, dans le structuralisme piagétien. Mais les théories des systèmes répandues dans les milieux proches de l'informatique sont conçues dans un autre esprit et souffrent, pensons-nous, de limitations qui les rendent inefficaces. Au point que les informaticiens les rangent le plus souvent dans la catégorie du "baratin". Notons ici deux de ces imitations.

Les théories des systèmes laissent une place insuffisante au temps. Elles sont statiques

Le temps est en général prix en considération dans la seule mesure où il ne met pas en cause la structure du système (cycle et sous-cycles du système).

Cette faiblesse est peut-être due pour une part aux modes concrets de représentation: le papier. Tout système intéressant présente un certain niveau de complexité: relations d'appartenance, relations d'ordre, relations, etc. Cela suffit à saturer les possibilités expressives d'une feuille de papier blanc avec ses deux dimensions (1)

--------

(1)Quelques notes sur la représentation sur papier . Il s'agit de représenter dans R2 des structures évoluant dans des espaces présentant un plus grand nombre de dimensions. Il y adonc une certaine perte. On la pallier par toutes sortes de moyens: projections multiples de la descriptive ou du dessin industriel, par exemple.

Mais, de plus, on a toujours des portions assez limitées de R2: la taille de cette feuille de papier (nota 92. la feuille A4 où j'écrivais l'original de ce texte il y a 20 ans). Ou d'un tableau blanc.

De plus, le papier a un grain. On ne peut pas descendre en dessous d'une certaine finesse de trait.

Il faut un minimum de contraste entre les différentes teintes.

La surface est en général orientée. Ce qui peut être une gêne dans certaines applications, bien que ce soit en général une aide. Orientation de haut en bas et de gauche à droite (en particulier, le temps croit toujours en allant vers la droite).

On peut utiliser un grand nombre de processus de globalisation et de réduction. Une croix, par exemple, sera perçue soit comme exprimant une partition de l'espace, si elle est très grande, soit comme un symbole, soit comme une catégorie de poitns, distingués par le caractère symbolique d'autres points (petits cercles, petits carrés, etc.).

-------

La représentation du temps exigerait une troisième dimension. Perspective, couleur, sont en pratique insuffisantes. Il n'est pas exclu que le visualisation graphique sur écran cathodique facilite la représentation des systèmes évolutifs. Dans l'état actuel des softwares graphiques et du coût des consoles, cela ne peut que rester très limité.

(Note, presque contemporaine. Des travaux de software auraient été réalisés sans aucune feuille de papier: le concepteur n'aurait utilisé qu'un écran cathodique).

On notera donc quelques éléments d'évolution... mais les phases de mutation se traiteront par passage à la page suivante, sans étude du phénomène transitoire.

Les théories des systèmes répugnent à formaliser les conflits

Conçues dans un esprit aristotélicien et cartésien, ces théories, plus ou moins explicitemnet, se veulent harmonisatrices. Les conflits seront donc décrits en annexe sous le titre "dysfonctionnements du système". Or toute l'histoire de la vie, de l'homme et de ses artefacts est profondément marquée par les situations conflictuelles. La concurrence commerciale en est la forme la plus civilisée.

En pratique, les informaticiens représentent en général un seul système dans un "environnement" supposé inorganisé et vide. On étudie peu les ensembles et populations de systèmes. Ce serait pourtant une voie intéressante, à ma connaissance inexplorée (note 92: Huberman, jeu de la vie), pour le développement de la sociologie théorique.

Dans le domaine informatique, la construction consciente et volontaire de systèmes mis au service des structures conflictuelles de l'entreprise serait peut-être plus efficace que les éternelles lamentations sur les "problèmes humains". Au lieu de demander au directeur de la production de sacrifier ses intérêts au bénéfice du MIS maison, pourquoi ne pas lui proposer explicitement l'emploi de l'informatique pour renforcer sa position dans ses conflits avec les directeurs financier et commercial... (*2011 : il y a eu un peu de cela dans le concept d'informatique straté:gique (Wiseman) ; mais plus clairement dans les jeux en général, les jeux d'entreprises, les systèmes de simulation pour militairres)

Cette approche permettrait l'étude d'un phénomène important dans le développement de l'informatique, pourquoi marque-t-elle le pas dans les pays de l'Est, malgré les dons certains des mathématiciens russes. Les soviétiques ont fait la théorie de grands systèmes... trop grands pour être viables dans l'état actuel de la technologie. A l'opposé, le monde capitaliste admet implicitement la lutte par la concurrence des entreprises. Il est admis que cette lutte peut être mortelle. Les systèmes peuvent donc rester plus petits, mieux ramener leur environnement à un néant non structuré, ou peu structuré. Et l'informatique a progressé.

Il y a sans doute d'autres raisons. Mais pourquoi refuser à de telles études, quand elles auront atteint le degré suffisant de rigueur, voire de formalisation, le titre de "fondamentales"?

Ici, le rapprochement avec la "lutte pour la vie" des évoutionnistes pourrait être éclairante.

-----

Note à peu près contemporaine je pense. Cela pourrait changer avec le progrès de la technologie. La taille accessible des ordinateurs change... cependant il y a des limites théoriques, équation du 5e degré...

Informatique et énergie

(note 92: se traduira par un dossier Informatique et Gestion quelques années plus tard, dossier qui d'ailleurs ne retiendra guère l'attention autant que je me souvienne)

Au delà du temps et des conflits, une omission plus profonde. Encore que peut-être plus clairement volontaire. On considère toujours que l'information n'est pas liée à des phénomènes énergétiques. Les concepteurs de hardware doivent résoudre des "problèmes calorifiques" (dissipation de la chaleur engendrée par le travail des circuits). Mais, comme par symétrie avec les "problèmes humains" de l'informaticien d'entreprise, ces questions sont considérées comme étrangères à l'informatique.

C'est peut-être une étude des relations entre énergie et information que pourraient naître les découvertes les plus fécondes pour un nouveau développement de l'informatique. Elles sont à faire. Tout ce qui est possible est d'indiquer quelques points d'insertion pour cette recherche.

Les démons de Maxwell

C'est peut-être à lui qu'il faut faire remonter la découverte de ce que information et énergie ne sont pas indépendants. Ou plus exactemnet d'un paradoxe exigeant de considérer le recueil d'une information comme un processus physique mettant en jeu de l'énergie. Des auteurs comme Brillouin ont ensuite approfondi la question et noté qu'information et énergie s'exprimaient par des formes mathématiques semblables, au signe près

Somme pi log pi

Mais il ne semble pas que l'on en ait tiré beaucoup de conséquences, sauf peut-être dans le domaine biologique (Prigogine).

Des ordres de grandeur très différents mais...

La séparation information-énergie est dans l'ensemble rendue légitime par la très grande disproportion entre les deux domaines: l'énergie consommée pour piloter un four électrique est négligeable par rapport à celle mise en jeu pour le chauffage.

Cependant, avec l'inflation du tertiaire et, parallèlement, le développement de grands automatismes, les ordres de grandeur pourraient se rapprocher. Et, de même que l'on pouvait considérer autrefois la géométride de l'univers concret comme euclidienne et la vitesse de la lumière comme infinie, il faut maintenant cerner de plus près le réel, de même, l'apparition de gigantesques systèmes de calcul obligera à y regarder de plus près. (*2011 : Google consomme des milliers de mégawatts, je crois)

Notons tout de même que le progrès est passé par une dissociation de l'acte au geste symbolique, du geste à la parole, du courrier par porteur à la lettre, au télégraphe, aux ondes hertziennes. Entrons-nous dans une nouvelle phase?

La porte et la boucle

Quand on présente la théorie des automates, ou les rudiments du hardware informatique, on utiliser des représentations de fonctions logiques. Par exemple une "porte" ET:

-------->

(inter) --------->

-------->

Dans ce cas, l'on ne voit pas ce qu'une étude énergétique pourrait apporter. Certes, il faut bien que cela fonctionne. Il y aura une petite perte. Mais l'impulsion d'entrée est porteuse d'une énergie suffisante. Tant que le nombre de portes mis en jeu est faible, on peut considérer que l'on a affaire à de purs "transducteurs" passifs, pouvant sans inconvénient être réduis àleurs fonctions logiques.

Mais il ne suffit pas de telles portes pour construire un automate. Il est important d'introduire des fonctions comme une mémoire, une constante, etc. On sera conduit à introduire des schéma du type

(porte union avec rebouclage sortie sur l'entrée)

Cette porte, dès qu'elle aura reçu une impulsion 2, continuer d'émettre des 1.

Mais un tel dispositif oblige à faire intervenir la notion de cycle (avec la temporalité), sans quoi le fonctionnement est incompréhensible. Et surtout, sur le plan énergétique, il est fondamentalement différent du précédent. En effet, pour conserver sa fonction logique, cette porte doit émettre indéfiniment des 2 une fois reçu le premier 2. Si celui-ci était porteur d'énergie, celle-ci sera progressivement consommée. La logique impose donc de supposer qu'il existe un apport d'énergie permettant à l'émission de se poursuivre.

Cet apport d'énergie n'est pas, en général, noté. Il paraît pourtant essentiel à une théorie complète des automates.

Le dispositif choisi est particulièrement probant, parce qu'il fait intervenir directement l'infini. Mais, dès que le nombre de portes est grand, les problèmes énergétiques se posent. La dégradation de l'information par le bruit rejoignant les pertes d'énergie. En tous cas, si l'on perd parfois de l'information, du moins dans le cas des automates, on n'en gagne jamais.

Transmission d'information sur une ligne. Toute transmission exige un courant porteur, une fréquence porteuse, dont l'entretien est nécessaire à la transmission. Il existe des relations assez complexes entre la quantité d'information transmise et l'énergie consommée.

Intuitivement, on admettra qu'il doit exister, pour une ligne donnée, un optimum. En dessous de celui-ci, l'énergie est trop faible et, par exemple, ne permet pas de distinguer les paramètres induits sur la ligne par d'autres sources d'énergie. Au dessus, c'est la ligne elle-même qui peut émettre des parasites et, à la limite, être détruite par un courant trop puissant. L'avantage de ce point est qu'il se prête à l'expérimentation et à la mesure précise. Les travaux de base existent sans doute, car la transmission de données a conduit à s'y intéresser. Il suffirait peut-être d'en tirer les conséquences.

Echanges énergie-information dans le domaine biologique. Je ne sais si la question a été clairement étudiée sous cet angle. Mais de nombreux exemples pourraient sans doute être trouvés; ici, l'on transforme souvent l'énergie en information: photosynthèse, échanges au niveau des membranes, etc.

Le théorème de Prigogine (exposé par Science et Avenir, juillet 1966), très schématiquement pose "qu'un système ouvert est en évolution constante et que cette évolution se fait dans le sens d'une moindre dégradation de l'énergie; si l'on interprète ce résultat, cela signifie que son rendement s'accroît sans cesse et que ses structures deviennent de plus en plus complexes et de plus en plus fonctionnelles". Si l'on rappelle que, dans ce contexte, un système ouvert est celui qui échange énergie et matière avec son environnement, l'interaction énergie/information devient tout à fait évidente et importante pour la compréhension de tous les systèmes, qu'ils soient informatiques ou biologiques.

Au niveau nucléaire, le défaut de masse introduit très suggestivement la relation; fait intéressant, et que l'on retrouverait souvent dans ces relations, le défaut est maximal pour une complexité "moyenne", correspondant un nombre de masse de l'ordre de 70. On trouverait sans doute nombre de points où cette relation est fortement marquée.

Mais ce sont certainement les relations d'incertitude de Heisenberg qui posent le problème de la manière la plus cruciale. Cruciale parce que désagréable pour notre entendement. Mais c'est peut-être précisément de là qu'il faut partir pour construire à nouveau. De même que le renouvellement des théories physiques est devenu posible à partir du moment où l'on a pris comme élément de départ le fait que la vitesse de la lumière représentait une valeur absolue, une limite infranchissable.

Le défaut de masse, en effet, ne fait appraître l'information que sous la forme de complexités de structure. Et il n'existe guère, actuellement, de théorie de la complexité qui permettent de la rattacher aisément et sans contexte à l'information.

Il en va autrement des relations d'incertidute, dont il y a lieu de rappeler l'essentiel.

Les relations d'incertitude de Heisenberg introduisent au coeur de la théorie atomique un aiguillon douloureux d'incertitude. Elle peut s'écrire sous diverses formes. On a par exemple (d'après Max Born, Structure atomique de la matière. Armand Colin 1971):

Delta x Delta p tildé h

signifiant que le fait de définir la position d'un électron avec une incertitude possile Delta x a pour conséquence que la particule acquiert dans la direction parallèle à la fente une quantité de mouvement de l'ordre de grandeur h sur Delta x... h représente une limite absolue pour la mesure simultanée de la position et de la quantité de mouvement. Plus on aura d'information sur un paramètre, moins on en aura sur l'autre. Rien ne permet d'ailleurs d'échanger information contre énergie, même sous une forme de la relation:

DeltaE x Delta t tildé h

où E représente l'énergie et t le temps. Mais on se rapproche d'une telle idée, et d'autant plus que h se définit par la formule:

E = h nu

où E est l'énergie d'un corpuscule, c'est à dire un quantum d'énergie.

Dans le cas de la lumière, en particulier, E est l'énergie d'un photon. Mais on sait que la quantité d'information que l'on peut transmettre sur une ligne est égale, en bits/seconde, à deux fois la fréquence de la porteuse. Si cette équivalence était maintnue, la constante de Planck relierait directement et très simplement l'énergie à la quantité d'information maximale transmissible par un rayonnement donné. Les choses sont sans doute plus complexes que cela...

La théorie de la relativité elle-même, autant qu'une théorie de la matière, peut être présentée comme une théorie épistémologique. Ce n'est sans doute pas par harsard que l' "observateur" y joue un si grand rôle. Et ses changements de systèmes d'axes peuvent se présenter comme le problème d'échange dinformation entre deux systèmes d'information distincts. A la limité, toute la théorie de la relativité pourrait être considérée comme un chapitre de l'informatique théorique. Et pourrait lui donner une solidité et un sens du concret qui lui manquent, de même que la cohérence.

La relativité présente d'ailleurs quelques avantages sur l'informatique théorique telle qu'elle nous est présentée. En effet:

- les objets étudiés par le physicien sont sans doute abstraits, mais constamment rattachés au monde concret par une expérimentation d'une ampleur unique; cependant, l'objet même se dérobe, au point de poser au physicien des problèmes sémantiques: que représentent finalemnet ses belles théories?

- le sujet, tout en restant théorique, n'est pas purement implicite comme dans les études informatiques sur les langages; de ce point de vue, les systèmes d'axes peuvent êre représentés comme des modèles très simplifiés de sujets échangeant des descriptions de l'univers.

Cependant, ayant admis que la communication entre deux observateurs ne peut jamais être instantanée, ces théories continuent d'admettre implicitement qu'elle peut être aussi précise que l'on veut. La vitesse est limitée, non le débit d'information. Il y a là une voie de recherche qui pourrait être fructueuse. En partant du niveau corpusculaire (débit informationnel d'un "rayon") on pourrait s'élever à des niveaux de complexité progressive (échangse d'information entre molécules de plus en plus grosses, cellules, organismes, corps sociaux).

Les ensembles flous sont un exemple de notion gâchée par une approche non énergétique. En se donnant des ensembles flous une idée aussi nette, Zadeh tue l'intérêt d'une notion qui pourrait être utile. Rappelons qu'il postule, en gros, que si un ensemble au sens habituel se définit par une relations d'appartenance x élément de E, qui est vraie ou fausse, un ensemble flou est celui pour lequel l'appartenance se mesure: x appartient plus ou moins à E, la valeur d'appartenance variant continûment (ou "prenant des valeurs dans n'importe quel ensemble ordonné") de 0 à 1.

Cette définition est choquante: elle contraint à se donner d'un ensemble blou une notion plus complexe que celle d'ensemble simple. Au demeurant, les applications en informatique semblent limitées. Certes, les opérations classiques de l'algèbre des ensembles peuvent s'appliquer aux ensemblesflous. Mais comme, de toutes façons, l'appartenance à un fichier ne peut être que binaire (l'article figure ou ne figure pas dans la pile de disques concernée), les ensembles flous ne peuvent être que des ensembles découpés, suivant les besoins, en fonction d'une valeur affectée aux articles. Il s'agit d'une sélection avec seuil. On n'avait pas attendu M. Zadeh. (Cependant, il est vraisemblable que, dans certains cas, la définition choisie permette des présentations simples de certaines questions).

Je pense, au contraire, que les véritables ensembles flous ne se prêtent pas à la définition, en chaque point, d'une fonction d'appartenance.

Les ensembles flous, et cette approche rendra bien mieux la richesse de l'intuition du sens commun, sont ceux sur les quels pèsent des relations d'incerditude, telles qu'on ne peut les lever sans perdre de l'information sur d'autres plans. On pourra préciser l'appartenance à l'ensemble, mais en perdant de l'information contenue dans l'élément. Je ne peux adhérer à un groupe politque, religieux ou conjugal, qu'en sacrifiant quelque chose de ma liberté, de mon autonoime, de ma définition, de ma nature.

Information et argent

Si les relations entre l'énergie et l'information n'ont guère été élucidées jusqu'à présent, malgré l'abandon des germes d'où une recherche aurait pu partir, c'est peut-être parce qu'il y faut faire intervenir un médiateur. Et le dernier auquel des scientifiques pourraient penser: l'argent, qu'on l'appelle franc lourd, livre flottante, dollar ou lingot d'or.

Scandale? Introduire Mammon au sein du désintéressement de la recherche fondamentale! Pourtant, là encore, les points d'ancrage ne manquent pas.

Avec de l'argent, on peut acheter de l'information aussi bien que de l'énergie. Avec un chèque, vous pouvez obtenir de l'essence, de l'électricité, de la lumière pour y voir clair, de la chaleur pour votre foyer, de quoi vous réchauffer le moral avec un bon déjeuner, l'huile de coude d'une femme de ménage, ou l'énergie revigorante de votre médecin.

Avec de l'argent, vous pouvez recevoir la télévision, un extrait de registre du commerce, un journal froid ou dynamique selon votre goût, ou des informations réconfortantes sur votre santé.

Bref, on pourrait comparer les prix: 10**6 bits d'information pour 0,50 F, 100 chevaux.heure pour 2 F, donc un bit = 0,5 10**-4 cheval heure.

(Note. Par exemple, un quotidien de 16 pages , chacune de 10 000 caractères de 6 bits par page.

100 km heure, soit une heure de marche d'une voiture de 100 Cv réels consommant dix litres an cent).

Jeu d'enfants? Bien sûr. A ce régime, on peut établir qu'un chou vaut 4 carottes, etc.

Ce ne serait qu'un jeu d'enfants, si d'autres voies ne montraient, chaque jour plus nettement, l'interaction plus profonde de l'argent, de l'énergie et de l'informtaion.

Les circuits intégrés digital/analogique d'Alsthom sont l'exemple d'une recherche sur le traitement de l'information. Ici, la transformation de signaux digitaux en tensions analogiques, et réciproquement, qui n'a de valeur que si elle se rèvèle plus économique que les solutions classiques.

En effet, sur le plan conceptuel, la méthode choisie (Le Monde du 24/5/72) est plus complexe que les méthodes traditionnelles, car l'on passe par une étape supplémentaire: la génération de tensions aléatoires. Si la méthode n'est pas économique, elle présente aussi peu d'intérêt que l'étude de n'importe quel cheminemnet farfelu imaginable pour passer du digital à l'analogique. Si elle est économique, elle prouve que les économies de concepts ne sont pas nécessairement des économies énergétiques et... économiques. Une mesure est peut-être possible.

Ce passage par le probabiliste est l'aléatoire est instructif, puisque l'on retrouve ainsi le coeur de la relations formelle énergie/information (Sigma de pi log de i).

Banques de données et abus de pouvoir. Ce problème d'actualité a quelques difficultés à trouver des solutions conceptuelles satisfaisntes. On peut faire apparaître des couples de désirs contradictoires:

- l'Etat doit faire respecter le secret de la vie privée, mais il doit largement informer le citoyen de ce qu'il fait;

- l'Etat doit cloisonner l'information pour éviter des transferts illicites, mais il ne peut accroître son efficacité et la qualité des services qu'il rend qu'en pratiquant la gestion intégrée (saisie unique des faits fondamentaux, réduction du nombre de fichiers faisant double emploi);

- le citoyen doit être protégé contre des interdictions étatiques excessivement répressives voire dictatoriales, mais il aussi être protégé contre les agissements dangereux de ses concitoyens "déviants"; seule une efficacité nouvelle des "forces de l'ordre" permettra de donner satisfaction à un voeu profond et de plus en plus répandu: la suppression des prisons et des asiles d'alinés, dont le caractère inhumain est de plus en plus ressenti.

Il s'agit ici de trouver des équilibres. Et d'autant plus que les solutions parfaites, les garanties absolues, sont impossibles. La seule protection absolue contre les déviants serait de les supprimer dès qu'ils se manifestent. D'ailleurs, c'est déjà trop tard... on voit où cela mène.

Il faut donc rechercher des optimums. Cela ne peut se faire qu'en se donnant des échelles de mesure. Liberté du citoyen et efficacité de l'Etat doivent pouvoir se mesurer dans la même unité.

Il est intuitivement assez clair que cette unité aura un caractère probabiliste. Et que l'appel aux unités monétaires, ou à des unités de type monétaire, apparaîtra souhaibable. Déjà, dans certains cas, de tels arbitrages sont classiques, comme la liberté sous caution. D'autres exemples ne manquerient pas.

Quelques points communs

Information, énergie, argent, mesurent des échanges. La théorie de l'information de Shannon est une théorie de la communication. Les principes de Carnot traitent de machines thermiques échangeant diverses formes d'énergie. C'est dans second temps seulement, quant à la connaissance que nous ena vons, que ces valeurs se stockent: banques de données, stockage chimique ou nucléaire.

Ces échanges ont tous gagné en efficacité en se distinguant progressivement de leurs supports matériels. L'information sur tables de pierre, tablettes d'argile, papier, ondes; véhiculées par porteur, poste, télégraphe, TSF. L'argent, troc, puis or, puis papier, puis ondes entre calculateurs et terminaux.

L'énergie hydraulique, charbon, pétrole, puis courant sur lignes haute tension (d'ailleurs alternative, ce qui la rapporche, peut être pas purement symboliquemnt, de la transmission de données).

Ces échanges conduisent tous, progressivemnet, à la constitution de réserves. C'est sans doute pour l'argent que la constatation est la plus évidente. Et l'avare comptant des sous est une des faces essentielles du système monétaire, avec les réserves d'or des grandes banques. Images de stocks s'opposant aux images de flux (*Note 92: la fin d'Eugénie Grandet, avec le Père changeant son or pour des rentes).

Le fait est chaque jour plus patent pour l'information et le terme de "banques de données" est on ne peut plus évocateur. Mais soulignons que l'on n'a pas attendu l'ordinateur: les premières banqeus de données ont été les bibliothèques. Et, avant elles, les tables de la loi: solennels embryons de banques, gravés sur la pierre dure du code d'Hammourabi, ou mystérieusemnet cachées dans l'arche d'alliance. Avant, ou simultanément, d'être des hommes de l'argent, les Juifs ont été des hommes du livre ("Bible" veut dire "livre" (ou "les livres)).

Quant à l'énergie, son stockage pose beaucoup de difficultés. C'est un vieux rêve que de garder la chaleur de l'été pour la retrouver en hiver. On a tout de même su faire des réserves: barrages hydro-électriques, bois. Et l'on a trouvé et recenser les réserves naturelles: tourbe, charbon, pétrole; et l'atome sous une autre dimension. Avant cela, on peut considérer que les réserves alimentaires, internes dans la bosse du chameau ou le ventre du riche, puis externes avec les greniers, la viande boucanées, etc. Là encore, la traduction juive est fort parlante: Joseph fait la conquête de Pharaon en lui conseillant de faire des réserves de blé.

Le souci actuel de rentabiliser l'informatique n'est peut être pas seulemnetp une contrainte externe, imposée aux informaticiens dans le cadre d'une conjoncture moins aisée qu'à d'autres moments. En effet, l'introduction de l'ordinateur a été l'un des moyens de rechercher la rentabilité de l'entreprise. Et c'est précisément parce que les utilisateurs ont appris, grâce à l'ordinateur, à meux gérer leurs moyens qu'ils ont clairement perçu le coût de l'informatique.

Au delà de quelques économies, la gestion des moyens de gestion est un intéressant phénomène de bouclage. Une réflexion approfondie sur le coût de l'informatique est difficile. Dans sa montée vers le plus grand cerveau, le phylum peut il réfléchir au niveau d'un individu... la méditation pourrait être fructueuse, au delà de l'efficacité du bon sens et de l'honêteté qui sont, bien sûr, les atouts essentiels de la rentabilité à un niveau de conscience donné.

Les paradoxes de la complexité

Il est une notion, essentielle au langage des systèmes, et qui pourtant souffre, dans sa définition même, de contradictions et de paradoxes qui gênent le développement théorique et donc l'approche unitaire pourrait permettre de mieux cerner la valeur. Je veux parler de la complexité.

C'est une notion essentielle

On ne cesse de la rencontrer dans la théorie des systèmes. Par exemple, un comptage rapide dans l'ouvrage "Analyse modulaire des systèmes de gestion, AMS", de Jacques Mélèse, j'ai compté quelque 52 fois le mot "complexité". Et il faudrait y ajouter, pour noter l'importance du concet, le terme inverse de simplicité, plus les différentes périphréses et avatars de la notion, y compris celui, fort significatif, de variété.

Mais on le rencontre dans bien d'autres domaines. Très fréquemment, bien sûr, chez Teilhard de Chardin. mais aussi bien chez Jacques Monod, qui parle dans son livre "hasard et nécessité" d'un mystérieux "gain de complexité", au moment où les chaînes protéïques s'enroulent sur elles-mêmes.

Elle est fort importante pour l'informatique. Chacun sait que l'on a automatisé d'abord les tâches "simples et répétitives". Dans des perspectives très pragmatiques, une étude sur la notation des programmeurs (Informatique et Gestion no..." notait la nécessité de mesurer la complexité des programmes.

D'ailleurs, on attend beaucoup de l'ordinateur comme "complexoscope". Tout récemment encore, André Danzin (Le Monde du 24-25/9/72) parle de l'informtaique come d' "un magnifique outil pour porter remède à l'oppression de la complexité".

Objectif ou subjectif?

L'ennui, c'est que cette complexité n'est pratiquement jamais définie. Ou que les définitions manifestent les paradoxes qu'elle porte. Pour le Petit Larousse, est complexe ce "qui contient plusieurs éléments différents et combinés d'une manière qui n'est pas immédiatement claire pour l'exprit" ou "est difficile à analyser". Il exprime très clairement l'ambivalence du terme: d'abord la pluralité des éléments, caractère objectif; ensuite la difficulté d'analyse, caractère subjectif. On peut compter objectivement le nombre des éléments. Mais ce qui paraîtra simple à l'un apparaîtra complexe à l'autre.

Pour Teilhard de Chardin ou Monod, la complexité se présente surtout comme objective: nombre d'atomes dans une molécule, nombre de cellules dans un organisme. De même, on peut chercher à mesurer la complexité d'un programme en nombre d'instructions, de boucles, etc.

Pour Mélèse, l'aspect subjectif prédomine (p. 51, op. cit.): "La complexité, caractère fondamental, apparaît donc comme l'incapacité de décrire tout le système et de déduire son comportement à partir de la connaissance du comportement de ses parties".

Il y a du vrai dans l'une et l'autre approche.

Positif ou négatif

Une autre contradiction apparaît. La complexité est-elle un bien ou un mal?

Dans l'ensemble, les "subjectivistes" (au sens du paragraphe précédent) voient la complexité comme négative, comme une difficulté ou une impossibilité. On trouverait une masse d'autorités en ce sens: têtes bien faites plutôt que bien pleines, le direct supérieur au "tortueux", et jusqu'à l'Evangile: "Que votre parole soit oui, oui, non, non; tout le reste vient du Malin". On parle de pollution par la complexité. Le névrosé fait des "complexes".

Le gauchisme, dans une certaine mesure, est une réactiont contre cette complication. On veut revenir à une vie plus simple. C'est, généralement, une des armes favorites des politiciens que de présenter à leur public des versions adéquatement simplifiées du réel. Comme les foules (et chacun d'entre nous) aime les idées simples, on est trop content de les suivre.

Mais les biologistes verront les choses d'un autre oeil. Pour Prigogine, le rendement s'accroit avec la complexité. Et l'on ne va pas dans la Lune avec un boulier, mais bien avec un des plus vastes "complexes" technologiques jamais réalisés. Et l'Evangile lui-même ne condamne pas l'effort intellectuel. Ne serait-ce que pour donner du pain à ceux qui n'en ont pas, il faut déjà une technologie agricole et boulangère qui n'est pas à la portée de n'importe quel primate. On parlera d'un outil "perfectionné".

Même chez Jacques Mélèse, dont on a vu l'approche très négative, la complexité prend un visage beaucoup plus séduisant quand elle prend le nom de "variété", et le texte est là très intéressant, très au coeur du paradoxe.

Page 66-67: "L'accroissement du contrôle recherche permanente dans la société industrielle, se heurte donc à la barrière de la variété des systèmes... qui disperse et désagrège les efforts s'ils ne sont pas orientés par une démarche améliorante; aussi la qualification du manager pourrait-elle presque se définir comme celle d'ingénieur en variété".

Mais, page 70: "Pour que l'adaptation puisse apparaître... (il faut notamment)... que la variété du système de contrôle puisse croître... cet accroissement ne peut être obtenu que par branchement du système de contrôle sur des générateurs de variété qui peuvent être soit:

- le système à contrôler lui-même (par feed-back);

- l'environnement;

- une black box;

- des hommes (à la fois environnement et black box)".

M. Mélèse objectera que variété et complexité ne sont pas la même chose. Il en donne pourtant pour définition "le nombre d'états différents que peut présenter le système", ce qui peut être considéréé comme une quantification, à quelques nuances près, de la première partie de la définition du Larousse. Mais il faudra préciser.

Le tout et la partie

Qu'est-ce qui est le plus complexe: le tout ou la partie? Une définition objective, par le nombre d'éléments, conclura à la plus grande complexité du tout, par une sorte d'addition des complexités.

Mais, en réalité, dans les objets hautement organisés notamment, la partie ne se peut comprendre que par le tout. Elle est donc presque plus complexe.

Pour un biologiste, chaque cellule porte tout le potentiel génétique de l'organisme, on pourrait donc poser que la complexité est la même...

Oui, la complexité est bien une notion complexe.

Recherche d'une définition

La première qui vient à l'esprit, c'est de compter le nombre des éléments. Premier pas, non sans intérêt, faute de mieux. Mais cela est insuffisant, car un cristal et un organisme biologique de volume voisin contiennent un nombre de molécules du même ordre de grandeur. L'intuition impose le biologique comme plus complexe.

Il faut donc parler d'éléments différents. Approche quiconduit à prendre comme mesure de la complexité le nombre de classes d'éléments différents. La complexité est le cardinal du quotient de l'ensemble des éléments du système par les différentes relations d'équivalence qui peuvent y être définies.

Point fort intéressant ici: la subjectivité intervient plus clairement. Les relations d'équivalence ne sont pas les mêmes pour tous, ni les mêmes pour une même personne selon les moments et les points de vue. En première analyse, toutes les françaises sont rousses. Un examen plus attentif fait découvrir (heureusement) quelques nuances.

Mais, attention! Cette réduction ne peut se faire aussi simplement. Tout organisme biologique peut se ramener aux atomes du tableau de Mendéléieff: quelques dizaines d'éléments différents! L'intuition montre d'ailleurs que, en quelque manière, "25 jetons blancs" est plus compliqué que "1 jeton blanc".

Il faut aller plus loin, et les relations d'équivalence nous mettent sur la voie: parler de classes, c'est en quelque façon parler d'abstraction, donc de langage. Pour que les classes soient distinctes, il faut pouvoir les identifier, les nommer.

D'où une idée plus satisfaisantes: la complexité d'un objet est la quantité d'information qu'il faut transmettre pour le décrire. (*En quelque sorte, j'ai retrouvé Kolmogorov tout seul)

Cette définition a plusieurs

avantages:

- elle est quantitative, et comme

telle objective;

- elle est subjective

(transmission);

- elle se rattache aisément à la

variété (d'ailleurs généralemnet exprimée en log à base 2).

Si l'on préfère, la complexité sera la longueur de la description nécessaire. Mais on se heurte immédiatement à des obstacles de taille.

Dans quel langage?

Pour un langage donné, on peut admettre que notre définition donne une mesure de la complexité des objets décrits: il suffit de compter la longueur en signes typographiques de la description ou, plus finement, de compter la quantité d'information transmise.

Mais il peut exister plusieurs langages, et les résultats obtenus varieront. Dans des cas simples, l'intuition montre même que, si un langage donné permet une classification donnée des complexités, on peut trouver un langage donnant la classification inverse.

Soit par exemple à décrire un long mot binaire. Si l'on observe dans ce mot des plages continues de 0 ou de 1, il paraîtra judicieux, plutôt que de donner une description complète, c'est à dire de recopier le mot, d'indiquer l'abscisse du début de chaque plage, c'est à dire de donner les coordonnées des points où la valeur passe de 0 à 1 et réciproquement.

Dans ces conditions, le mot binaire le plus simple est celui qui est composé entièrement de 0 ou de 1, le plus compliqué est celui qui change de valeur à chaque bit.

(On notera que la méthode choisie, très intéressante s'il y a un petit nombre de grandes plages, est très peu efficace s'il y en a beaucoup de ptites. La méthode est donc d'une efficacité équivlente à la méthode de recopie pour un nombre moyen de plages qu'il est assez aisé d'estimer").

(note 92. Il serait peut-être plus intéressant de faire ce calcul que je ne le pensais à 'lépoque ; en fait, les recherche sur la compression sont allées dans ce sens)

Si l'on choisit pour méthode d'indiquer l'abscisse de chaque point où la valeur ne change pas, l'objet le plus simple devient celui qui change de valeur à chaque bit, et le plus compliqué est l'objet entièrement "blanc" ou "noir". CQFD.

En pratique, le langage courant dispose en général de plusieurs moyens de description. On peut donc perfectionner la définition: "la complexité est la quantité d'information minimale nécessaire pour décrire l'objet".

Cela permet, en théorie au moins, de donner une définition satisfaisante pour un sujet donné (la complexité sera pour lui mesurée dans le meilleur des langages qu'il comprend) ou pour un corps social (extension de la définition précédente).

Cependant, le caractère objectif de la complexité disparaît. Sauf à admettre, par exemple, qu'il existe un "langage étalon" dont la définition serait sans doute possible au sein d'une discipline donée.

Objet mathématique, objets "naturels", artefacts

Ce n'est pas par hasard que nous avons choisi un mot binaire comme objet à décrire. La situation est en effet tout à fait différente quand on traite d'objets mathématiques, d'objets naturels, ou d'artefacts, c'est à dire fabriqués par l'homme.

Pour ce qui est des objets naturels: tel caillou, une pomme,le système solaire, le caractère de mon voisin de palier, cest pratiquement un Credo du monde moderne, de la science et même de l'éthique, qu'aucune définition n'en épuisera jamais la richese. Il est donc impensable d'en envisager une définition "en soi", complètement objective.

La complexité ne peut donc se définir que par rapport à un objectif. La complexité de tel itinéraire de Paris à Grenoble peut se mesurer, pour un français moyen (qui ne connaît pas sa géographie). C'est le plus petit exposé qui lui permettra effectivemnet de suivre cet itinéraire au volant de sa voiture.

Cette mesure pourrait être pratiquemnet faite, à partir d'un échantillon approprié de population. elle n'a absolument rien d'objectf. Elle n'est pas sans intérêt.

Parmi les exemples intéressants, notons la complexité des lois scientifiques. L'objectif sera par exemple de prévoir tel mouvement planétaire. Ici, la notion de complexité est assez clairement définissable dès qu'on s'est fixé un niveau donné de précision. Elle croîtra rapidement dès que l'on voudra une précision supérieure, avec l'apparition de niveaux où les rapports complexité/efficacité de la prévision seront particulièement bons.

Pour les objets mathématiques, dont la nature est supposée toute entière contenue dans leur définition, il semble possible de définir une complexité d'une manière complète. Dans le cadre bourbakien, par exemple, il est posé que tout peut s'exprimer par des lettres, et quatre signes logiques: carré, tau, signe logique ou, signe logique négation, complété par des liaisons entre le tau et le carré. Il serait donc aisé, en théorie du moins, de compter le nombre des signes, et d'en déduire la quantité d'information transmise. Par exemple, l'ensemble vide s'écrit... si l'on admet que l'alphabet à utiliser comprte 26 lettre, plus 5 signes logiques, soit 31 signes, et peut être représenté par des mots de 5 bits. Qu'il faut indiquer pour chaque barre de laison son origine et son extrémité soit, our un terme court comme celui-ci, deux fois quatre bits par barre de liaison, on pourrait dire que la complexité de l'ensemble vide est, dans le langage formalisé de Bourbaki, de 12 caractères de 6 bits, soit 72 bits, plus 3 barres de liaison à 8 bits,soit en tout 96 bits.

Cela n'est sans doute pas sans intérêt théorique. Dans la pratique, il faut une quantité d'information bien supérieure à 96 bits pour faire comprendre la notion d'ensemble vide à quelqu'un qui apprend les mathématiques modernes. Ce qui ne changerait pas la validité d'une complexité objective... s'il n'y a avait une ojbjection plus générale: la description des objets mathématiques dans un langage formalisé suppose en fait l'emploi d'un méta-langage, non seulement sur le plan pédagogique mais aussi sur le plan de toute communication. Il y a donc ici une complexité implicite, et virtuellement infinie, comme pour les objets naturels. Cependant, est-il exclus de considérer que la complexité ainsi mesurée représente une sorte de limite, atteinte dans la communication entre deux mathématiciens ayant assimilé les mêmes notions au moyen d'un même métalangage?

Ce n'est certainement pas aussi simple, et nous sommes au rouet, car les complexités dépendront du cheminement constructif suivi. Dans une construction axiomatique donnée, les objets les plus simples seront ceux définis directement par les axiomes, la complexité croissant de proche en proche au fur et à mesure de la constructino. Mais une autre axiomatique donnera une autreéchelle de complexité. Nous sommes au rouet. A moins de prendre pour définition de la complexité, pour le cas des objets mathématiques, la longueur minimale (en termes de quantité d'inforamtino) du système d'axiomes le plus simple suffisant à les définir.

Je crains que l'on n'en revienne toujours plus ou moins à une situation analogue à celle des objets naturels: la complexté "absolument objective" est toujours infinie. Mais, ici, la nature des objectifs poursuivis permet assez facilement la mise entre parenthèses du facteur infini et la mesure sur l'autre facteur (Que les mathématiciens me pardonnent un texte probablement assez barbare).

On se trouve dans un troisième cas avec les artefacts. Ici, une description complète est possible: c'est celle qui permet deconstruire un artefact semblable.

En pratique, les choses ne sont pas aussi simples. Existe-t-il deux artefacts semblables? Chacun sait que, même dans une production à la chaîne, il y a des différences entre les différents "numéros" d'un même modèle.

Pour nombre d'oeuvres, d'ailleurs, il n'existe pas vraiment de description suffisante. Au delà du manuel du "parfait petit menuisier", dont la quantité d'information transmise peut bien sûr être mesurée, il existe une transmission d'expériences, de tours de main, qui sont potentiellemne d'une complexité infinie.

Je crois finalement que la meilleure définition possible, pour l'instant, de la complexité d'un objet, c'est "le prix qu'il payer pour le maitriser intellectuellement".

(* 2011. Là je suis vraiment gonflé. Mais ce n'est pas idiot. Après tout, la complexité d'une oeuvre d'art (en comptant tout ce qu'il y a autour), c'est le prix qu'elle peut se vendre sur le marché).

Remarques sur cette définition

- Elle nous ramène bien dans le cadre information/énergie/argent dont nous avons vu la grande efficacité potentielle

- Elle fait assez bien la synthèse de l'objectif et du subjectif. Le "riche industriel" maîtrise plus aisément le même objet. Le prix sera le même pour tous, mesuré dans une unité qui reste à définir, mais que, en attendant, on prendra à la théorie de l'information. (*2011 : pour celui qui dispose de revenus suffisants, ou plus exactement de revenus assez nettement supérieurs à ses "besoins", la vie est sensiblement simplifiéé).

Mais ce prix ne représente pas la même chose pour le "pauvre" qui devra payer de longs efforts (par analogie, mettons d'un an de salaire) et pour le "riche" savant qui en fera le tour en deux minutes. Pour Dieu, tout est parfaitement simple.